Bạn thường xuyên thấy thư mục gốc của website xuất hiện 1 file được gọi là Robots.txt. Vậy, file Robots có ý nghĩa là gì? Liệu rằng sự có mặt của tệp này có đem lại lợi ích gì cho website hay không? Hãy cùng chúng tôi tìm hiểu vấn đề này trong nội dung bài viết dưới đây. Đầu tiên, hãy cùng các chuyên gia của Spseo.vn định nghĩa về tệp tin này nghĩa là gì nhé.

Robots.txt là gì?

Robots.txt chính là một kiểu tệp tin đặc biệt thuộc vào thư mục gốc của trang website. Nhờ có tập tin này mà Google biết được phải thu thập dữ liệu website ở đâu? Robots txt hỗ trợ rất lớn trong việc lập chỉ mục đối với website. Bởi vì:

- Việc làm đầu tiên của Googlebot sau khi truy cập vào trang website của bạn. Đó là, Google sẽ truy tìm và kiểm tra các nội dung thuộc vào file Robots.txt đầu tiên.

- Sau đó, Googlebot sẽ căn cứ vào các quy định được hình thành trong tệp tin này. Từ đó, Google sẽ tạo ra một loạt những danh sách gồm các links để thu thập dữ liệu.

- Cuối cùng, Google sẽ tiến hành việc lập chỉ mục đối với các nội dung này của website.

Do đó, yếu tố đầu tiên để Google có thể hiểu rõ nhất về trang web của bạn. Đó chính là các nội dung cần thiết được gói gọn trong file Robots. Thông thường thì nội dung này sẽ được công khai trên mạng internet.

Lợi ích của việc sử dụng Robots.txt cho website

Robots.txt đem tới một lợi ích vô cùng thiết thực cho website. Đặc biệt, tập tin này còn ảnh hưởng trực tiếp đến chiến lược làm seo của người dùng.

- Điều gì sẽ đến với bạn khi website không có tệp tin Robots. Một website bị thiếu đi mất tệp Robots thì công cụ tìm kiếm sẽ khó lòng định hình được các trang trên website của bạn. Điều này sẽ làm kéo dài thời gian lập chỉ mục cho website. Đương nhiên, quá trình Google index website sẽ diễn ra chậm hơn.

- Điều gì sẽ đến với website của bạn khi tệp tin Robots này bị sai thông tin. Đương nhiên, Google sẽ hiểu sai về nội dung website của bạn. Điều này, sẽ khiến cho các nội dung mà công cụ tìm kiếm Google thu thập được không khớp nhau. Vì thế, website của bạn khó lòng có tên trong danh sách Google top được.

Cấu trúc của file Robots.txt

File dữ liệu Robots.txt được hiển thị ở dạng 1 cấu trúc khá đơn giản. Trong đó, có một số từ khóa hay giá trị mà bạn có thể sử dụng. Các giá trị này sẽ được xác nhận trước, chẳng hạn như:

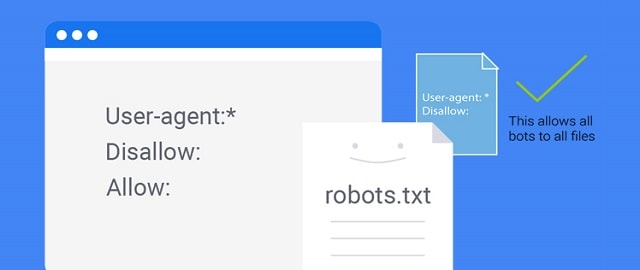

User-Agent

User-Agent dùng để chỉ định các dữ liệu nào được đưa vào chỉ mục. Nếu bạn muốn tất cả các thông tin thu thập được đưa vào mục này. Bạn có thể để dấu * phía sau các thông tin dữ liệu thu thập. Nếu bạn chỉ muốn chỉ định đích danh dữ liệu nào thì sẽ ghi cụ thể tên thông tin đó. Chẳng hạn như:

- User-Agent: * Bao hàm toàn bộ thông tin của các trình thu thập dữ liệu.

- User-Agent: Googlebot – Bao gồm các thông tin của trình thu thập Googlebot.

Disallow

Chỉ thị hướng dẫn cho các bot trong việc tìm kiếm thông tin dữ liệu. Điều này sẽ không áp dụng cho các dữ liệu là Url hay 1 phần của website.

Giá trị của một Disallow được hiển thị ở một tệp tin, thư mục cụ thể hay 1 Url. Bạn có thể tham khảo yếu tố này trong file của Robots.txt.

Allow

Allow chỉ áp dụng cho công cụ tìm kiếm Googlebot. Đây chính là chỉ thị điều hướng tới những trang hay thư mục nào được phép truy cập. Trong trường hợp này, nếu thư mục gốc không được phép truy cập. Nhưng Allow vẫn cho phép bot truy cập tới thư mục con cụ thể nào đó. Chẳng hạn như:

- User-Agent: *.

- Disallow:/image.

- Allow:/image/photo1

Điều này có nghĩa là, chúng tôi đang chặn thư mục image. Nhưng thư mục photo1 vẫn được truy cập để tiến hành lập chỉ mục.

Crawl-delay

Thông số này được hiểu như 1 thời gian cụ thể nào đó mà bạn đưa ra quy định. Từ đó, trình thu thập dữ liệu sẽ phải chờ khoảng thời gian crawl-delay quy định. Sau khoảng thời gian này trình thu thập dữ liệu mới được thực hiện tác vụ của mình.

Thông thường, giá trị bạn phải nhập cho Crawl-delay là mini giây. Ngoài ra, bạn có thể sử dụng yếu tố để kiểm soát hàng ngàn trang web. Từ đó, bạn sẽ dễ dàng kiểm soát được các yêu cầu từ phía trình thu thập dữ liệu.

Sitemap

Sitemap là một dữ liệu luôn có mặt ở tập tin Robots. Yếu tố này giúp cho trình thu thập dữ liệu dễ dàng hiểu cấu trúc website của bạn. Tuy nhiên, dữ liệu này luôn được mặc định là có trong tập tin Robots. Vì thế, ngay cả khi người dùng không chỉ định xml Robots.txt trong Robots. Thì trình thu thập dữ liệu và tìm kiếm vẫn có thể tìm được data này.

Ngoài ra, trong Robots.txt có phân biệt giữa chữ hoa và chữ thường. Vì thế, bạn cần phải lưu ý vấn đề này trong việc tạo file Robots. Vậy, cách thức tạo file tệp tin này cho người dùng ra sao?

Cách tạo file Robots.txt cho người dùng

Để có thể tạo 1 file Robots cho website vô cùng đơn giản. Bạn chỉ cần biết một chút về code và sử dụng trình soạn thảo văn bản trên máy tính. Chẳng hạn như Notepad hoặc World. Tuy nhiên, chúng tôi khuyên bạn là nên sử dụng Notepad là hợp lý nhất.

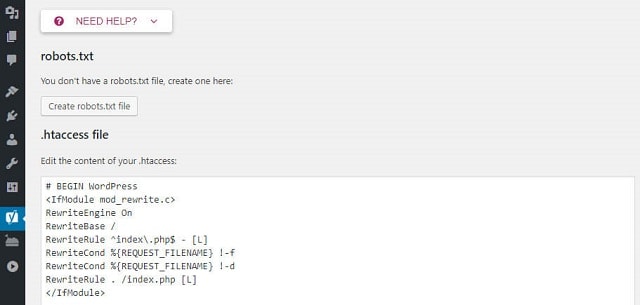

Bước 1: Kiểm tra xem website đã có Robots.txt chưa?

Đầu tiên, người dùng sẽ truy cập vào trang web để kiểm tra xem file Robots đã xuất hiện ở trang web của bạn chưa? Bằng cách: Bạn gõ vào đường link tương ứng như sau:

- https://tên tiền của trang web.com/robots.txt.

- Sau đó, bạn sẽ thấy trong đoạn code xuất hiện các yếu tố User-Agent và Allow. Điều này có nghĩa là website của bạn đã có file Robots rồi.

Trường hợp website chưa có, bạn có thể copy file Robots của website khác. Sau đó, bạn sẽ tiến hành các cách để chỉnh sửa file dữ liệu này. Bằng cách:

Bước 2: Chỉnh sửa file Robots

Đầu tiên, người dùng sẽ truy cập vào thư mục gốc của website. Sau đó, bạn sẽ tìm tới tệp tin trống Robots.txt và mở ra. Lúc này, hệ thống sẽ tự động tải tệp tin này về máy tính của bạn. Người dùng sẽ tiến hành các bước chỉnh sửa cho dữ liệu này.

Nếu bạn không hiểu về code, thì bạn có thể lấy dữ liệu Robots copy của trang khác. Sau đó, bạn sẽ tiến hành chỉnh sửa các thông tin hợp với dữ liệu của mình.

Sau khi bạn tiến hành chỉnh sửa và lưu lại các thay đổi có trong file Robots. Lúc này, bạn sẽ tiến hành tải tệp tin này lên ứng dụng của bạn là xong.

Bước 3: Kiểm tra tính xác thực của file Robots

Để có thể kiểm tra được các nội dung bên trong của file Robots định dạng txt Bạn có thể truy cập trực tiếp vào thư mục gốc để mở tập tin này lên và kiểm tra. Tuy nhiên, cách làm này sẽ làm mất khá nhiều thời gian của bạn. Nhất là đối với các website lớn có dữ liệu nhiều. Vì thế, bạn có thể sử dụng một công cụ mà Google Search Console đem tới. Đó là: sử dụng công cụ Robots.txt tester bằng cách:

- Đầu tiên, người dùng sẽ đăng nhập vào tài khoản Google Search Console. Sau đó, bạn tìm kiếm vào nhấp vào txt Tester thuộc vào tùy chọn Crawl.

- Cuối cùng, người dùng sẽ nhấp vào nút TEST là xong.

Nếu mọi thứ trong file Robots của bạn là ổn định. Nút Test sẽ chuyển sang trạng thái màu xanh để thông báo tạo file Robots.txt thành công cho bạn. Ngược lại, nếu có sự cố xảy ra ở đâu? Thì sẽ có đường kẻ đánh dấu màu đỏ xuất hiện ở sự cố đó.

Như vậy, các thông tin về Robots.txt không làm bạn mất nhiều thời gian để tìm hiểu. Chủ yếu, người dùng nên học cách tạo và chỉnh sửa file Robots này. Tuy nhiên khi thực hiện vấn đề này. Bạn tuyệt đối không được chặn mất công cụ tìm kiếm của Google nhé. Bởi vì, hành động này sẽ khiến cho Googlebot không truy cập được vào website của bạn.

Xem thêm